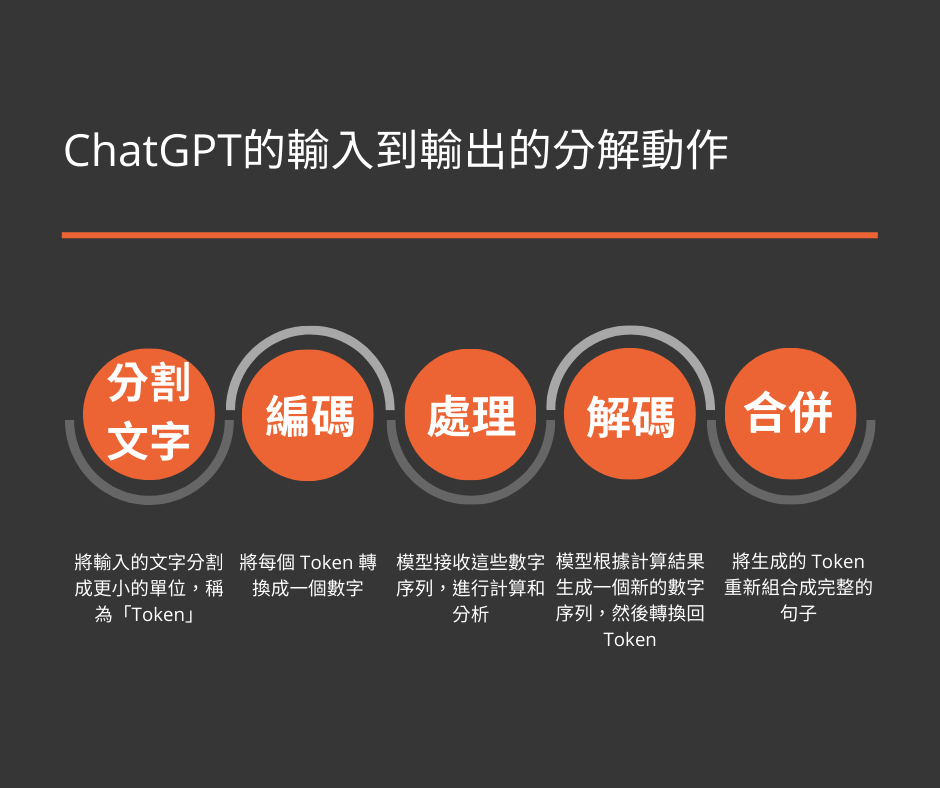

ChatGPT 使用的 Token 機制是一種將文字轉換成電腦可以理解和處理的方式。這個過程可以用以下幾個簡單的步驟來解釋:

- 分割文字:將輸入的文字分割成更小的單位,稱為「Token」。Token 可以是一個字、一個詞或者一個字符,具體取決於語言和模型的設計。

- 編碼:將每個 Token 轉換成一個數字,這個數字是該 Token 在模型詞彙表中的索引。這樣,電腦可以用數字來表示原始的文字信息。

- 處理:模型接收這些數字序列,進行計算和分析,以便理解輸入的文字含義並生成回應。

- 解碼:模型根據計算結果生成一個新的數字序列,然後將這些數字轉換回 Token,形成文字回應。

- 合併:將生成的 Token 重新組合成完整的句子,以便用戶能夠理解和閱讀。

通過這個 Token 機制,ChatGPT 能夠在用戶提供的輸入信息基礎上,生成相應的回應。整個過程涉及將文字分解、轉換成電腦可以處理的數字,以及將模型生成的數字序列重新組合成有意義的文字。這樣,我們可以與 ChatGPT 進行自然語言對話,並獲得有用的信息和解答。

ChatGPT最多可以輸入幾個Token? 最多輸出幾個Token?

ChatGPT的最大輸入和輸出token數量取決於模型的大小和參數配置。在OpenAI所發表的GPT-3.5 turbo模型中,其最大輸入與輸出token數量為4096。而GPT-4則增加了四倍,最大到32K個(不過,目前只開放特定用戶),目前公開使用的ChatGPT4的最大Token為8192。這個數量在實際應用中可能會有所不同,因為它受到硬體和記憶體等因素的限制。此外,為了更好地處理長文本,GPT-3還提供了streaming API,允許使用者將長文本拆分為較小的塊來處理,並生成連貫的輸出文本。

為什麼要限制Token的數量大小?

限制 Token 的數量大小主要是由於以下幾個原因:

- 計算資源限制:深度學習模型,特別是像 GPT 這樣的大型語言模型,需要大量的計算資源來進行推理和訓練。隨著 Token 數量的增加,計算需求會呈指數級增長,這可能導致計算過程變得非常緩慢,甚至無法完成。

- GPU 記憶體限制:深度學習模型通常在 GPU 上運行,而 GPU 的記憶體是有限的。增加 Token 數量會增加 GPU 記憶體的需求,超過某個臨界點後,模型可能無法在 GPU 上正常運行。

- 上下文窗口限制:GPT 模型在設計時有一個固定的上下文窗口大小,用於捕捉輸入文本中的相關信息。這個窗口大小限制了模型可以考慮的文本範圍。當超過這個範圍時,模型可能無法充分理解輸入的上下文,這會影響生成的回應的質量和相關性。

- 避免過度計算:限制 Token 數量有助於確保模型不會浪費計算資源在過長的文本上。在許多情況下,對於短文本的處理已經足夠滿足需求。限制 Token 數量可以讓模型更高效地運行,並縮短回應時間。

- 模型訓練困難:隨著 Token 數量的增加,模型訓練過程變得更加複雜,可能導致收斂速度變慢甚至無法收斂。限制 Token 數量有助於降低模型訓練的難度,提高模型的穩定性和性能。

總之,限制 Token 數量是由於計算資源限制、GPU 記憶體限制、上下文窗口限制以及避免過度計算和降低模型訓練難度等因素所致。這些限制確保了模型能夠高效運行,同時保持良好的性能和生成回應的質量。然而,隨著深度學習技術的發展和硬件性能的提升,未來可能會有更強大的模型能夠處理更多的 Token,進一步提升語言理解和生成能力。

ChatGPT模型總共有多少個已知Token?

ChatGPT(基於 GPT-3)的詞彙表大小取決於模型的具體版本。GPT-3 有多個版本,它們的大小和性能有所不同。詞彙表大小通常在 50000 到 500000 之間,但具體數量可能因模型而異。值得注意的是,GPT-3 的詞彙表包含了各種語言的 Token,不僅僅是英語。這使得 GPT-3 能夠理解和生成多種語言的文本。詞彙表中的 Token 包括單詞、字符和一些特殊符號,例如換行符和空格等。

GPT模型接收數字序列後,如何進行計算和分析,以便理解輸入的文字含義並生成回應?

GPT 模型在接收數字序列後,通過以下幾個主要階段進行計算和分析,以理解輸入的文字含義並生成回應:

- 嵌入層(Embedding layer):模型首先將輸入的數字序列(Token 索引)轉換為連續的向量表示。這些向量在高維空間中捕捉了詞彙之間的語義和語法關係。

- 自注意力機制(Self-Attention Mechanism):GPT 使用了 Transformer 結構作為核心。在 Transformer 中,自注意力機制允許模型關注輸入序列中的不同位置之間的相互關係。這有助於模型捕捉上下文信息以及在句子或段落中的長距離依賴。

- 多層 Transformer:GPT 模型通常包含多層 Transformer 結構,每一層都在前一層的基礎上進行進一步的抽象和表示。這些層次可以捕捉不同級別的語義和語法結構,從而讓模型更好地理解輸入的含義。

- 語言模型目標:GPT 是一個生成式預訓練的語言模型,其目標是預測輸入序列中下一個 Token。在訓練過程中,模型學會了生成語法結構合理且語義連貫的文本。

- 解碼階段:在生成回應時,GPT 使用自回歸解碼(Autoregressive decoding),這意味著它一次生成一個 Token,並將之前生成的 Token 作為新的輸入。模型會基於輸入的上下文和已生成的 Token 來預測下一個最可能的 Token。

- 概率分布與抽樣策略:GPT 模型輸出的是每個可能 Token 的概率分布。通常,我們會使用某種抽樣策略(例如貪婪解碼、集束搜索或者拓撲抽樣)來從這個概率分布中選擇最終的 Token。

- 生成終止條件:當達到特定條件時(例如生成了特定數量的 Token 或遇到特定終止符),模型會停止生成。然後將生成的 Token 序列解碼成最終的文本回應。

通過這些階段,GPT 模型能夠對輸入的數字序列進行計算和分析,理解其語義和語法結構,並根據上下文生成相應的回應。這使得 GPT 模型具有了強大的自然語言理解和生成能力,能夠處理各種語言任務,如問答、摘要、翻譯等。

GPT 模型的成功在很大程度上歸功於其 Transformer 架構、自注意力機制和生成式預訓練策略。這些特性使得模型能夠捕捉輸入文本中的語義和語法信息,並將其應用於生成高質量的回應。在不斷地優化和發展過程中,GPT 模型有望持續提升其語言能力,為各種應用領域提供更加強大和實用的解決方案。這包括自然語言對話、知識提取、創意寫作、智能助手等等。同時,隨著深度學習技術的進步,我們也將繼續見證 GPT 及其衍生模型在理解和生成語言方面取得的突破和創新。

在一系列連續的聊天中(session),ChatGPT如何保持輸出內容的一致性和連貫性?

在一系列連續的聊天中,保持 ChatGPT 輸出內容的一致性和連貫性是具有挑戰性的。然而,有一些方法可以幫助提高模型在這方面的表現:

- 上下文信息:在聊天過程中,將之前的對話內容作為上下文一起提供給模型,這樣模型就能理解到前後對話之間的關聯,並在這個基礎上生成更加連貫的回應。

- 使用 Session:為每個用戶創建獨立的會話 (Session),以便在整個對話過程中保持輸出內容的一致性。這有助於模型記住特定用戶的需求、喜好和上下文信息。

- 修改模型生成參數:通過調整模型生成參數,例如溫度(temperature)和集束搜索(beam search)寬度,可以影響模型生成回應的風格和一致性。例如,降低溫度會使模型更加保守,生成更加確定性強的回應,有助於提高連貫性。

- 在生成過程中設定限制:對模型生成的回應進行限制,如最大生成長度、最小生成長度等,可以避免模型產生過短或過長的回應,確保輸出內容保持一定的連貫性。

- 使用上下文標記:在輸入上下文中添加特定的標記或指令,以引導模型生成更具連貫性和一致性的回應。例如,在對話開始時,可以向模型提供有關目標風格和語境的信息。

- 對模型進行微調:根據特定的應用場景和目標,對模型進行定向微調。通過使用與目標任務相關的數據集,訓練模型以適應特定的對話風格和場景。這樣可以使模型在生成過程中更容易保持一致性和連貫性。

- 實時評估與反饋:根據用戶反饋和滿意度評分,對模型進行實時評估,並根據評估結果調整模型參數,以提高模型在連續聊天中的一致性和連貫性。

請注意,儘管上述方法有助於提高 ChatGPT 在連續聊天中的表現,但由於模型的本質限制,保持完美的一致性和連貫性仍然具有挑戰性。模型可能仍會偶爾產生不一致或不連貫的回應。然而,隨著模型技術的不斷發展和優化,我們可以期待未來的 GPT 模型將在保持一致性和連貫性方面表現得更好。這將使 ChatGPT 可以更有效地應對連續聊天場景,為各種應用提供更加自然和高質量的對話體驗。

上下文信息的Token與最新輸入的Token如何搭配?

在使用 ChatGPT 進行連續聊天時,上下文信息的 Token 和最新輸入的 Token 的搭配至關重要。通常,我們將整個對話歷史(包括用戶和模型的互動)作為上下文信息,並將其與最新的輸入一起提供給模型。這樣可以幫助模型理解到前後對話之間的關聯,並在這個基礎上生成更加連貫的回應。

具體操作如下:

- 將對話歷史分為 Token:將先前的對話內容(包括用戶輸入和模型回應)分為 Token。這些 Token 會按照在對話中出現的順序進行排列。

- 添加特殊標記:為了幫助模型區分用戶和模型的對話,可以使用特殊標記(如

<user>和<bot>)來表示對話中的角色。這些標記會在相應的對話片段之前插入,以提供明確的上下文角色信息。 - 拼接 Token:將上下文信息的 Token 和最新輸入的 Token 按照對話的先後順序拼接在一起。這樣,模型就能夠理解整個對話歷史,並基於這些信息進行回應。

- 處理 Token 長度限制:由於模型有最大 Token 數量的限制,可能需要對拼接後的對話進行截斷或其他處理,以確保輸入 Token數量不超過限制。在進行截斷時,應盡量保留對話中的重要信息,以免影響模型生成回應的能力。

- 輸入模型:將拼接後的 Token 序列輸入模型。模型將基於此序列生成回應,並將生成的回應以 Token 的形式輸出。

- 解碼輸出:將模型輸出的 Token 解碼成自然語言文本。這將成為模型對最新輸入的回應。

通過以上步驟,ChatGPT 能夠根據完整的對話歷史(包括上下文信息的 Token 和最新輸入的 Token)生成合適的回應。在這個過程中,將對話歷史和最新輸入組合在一起,有助於確保模型能夠充分理解上下文,並在此基礎上生成具有連貫性和一致性的回應。

需要注意的是,由於 GPT 模型有最大 Token 數量限制,可能需要在保留重要信息的前提下對對話歷史進行裁剪。此外,根據具體應用場景和需求,可能需要調整拼接策略,例如添加額外的特殊標記或元數據信息以引導模型生成更精確的回應。隨著模型的不斷優化和深度學習技術的進步,未來的 GPT 模型可能會在保持上下文一致性和連貫性方面表現得更好,為用戶提供更加自然且高質量的對話體驗。

ChatGPT如何判斷歷史對話的重要性並進行裁剪?

ChatGPT 並不直接判斷歷史對話的重要性進行裁剪。然而,開發者在處理對話歷史時,可以使用一些策略來儘量保留重要信息。以下是一些建議:

- 保留最近的對話:由於最近的對話通常與當前主題最為相關,可以優先保留最近的對話片段。在必要時,可以刪除較早的對話內容以適應模型的最大 Token 限制。

- 保留關鍵問題和回答:在對話歷史中,有些問題和回答可能對當前主題具有重要意義。可以嘗試識別這些關鍵信息並保留它們,以確保模型在生成回應時能夠充分理解上下文。

- 自訂裁剪策略:根據具體的應用場景和需求,可以開發自定義的裁剪策略,例如保留最長的對話片段、保留特定的角色(如用戶或機器人)的對話內容等。這樣可以避免刪除重要信息,同時保持模型的最大 Token 數量限制。

- 創建上下文窗口:將整個對話歷史劃分為多個上下文窗口,每個窗口包含一定數量的對話片段。在生成回應時,只需使用最近的幾個窗口內容,而不是整個對話歷史,這樣可以避免因為過多的歷史對話信息而導致模型過於冗長和不精確。

需要注意的是,裁剪對話歷史可能會對 ChatGPT 的回應質量產生影響。因此,在進行裁剪時,需要在保留重要信息的前提下,儘量保持上下文的完整性和一致性。同時,需要根據具體的應用場景和需求,選擇合適的裁剪策略以提高 ChatGPT 的回應質量。